Cette fiche technologique sur le deep leaning synthétise quelques faits jugés significatifs par nos Fellows dans le cadre de l’activité Presans Platform.

1. Qu’est-ce que le deep leaning ?

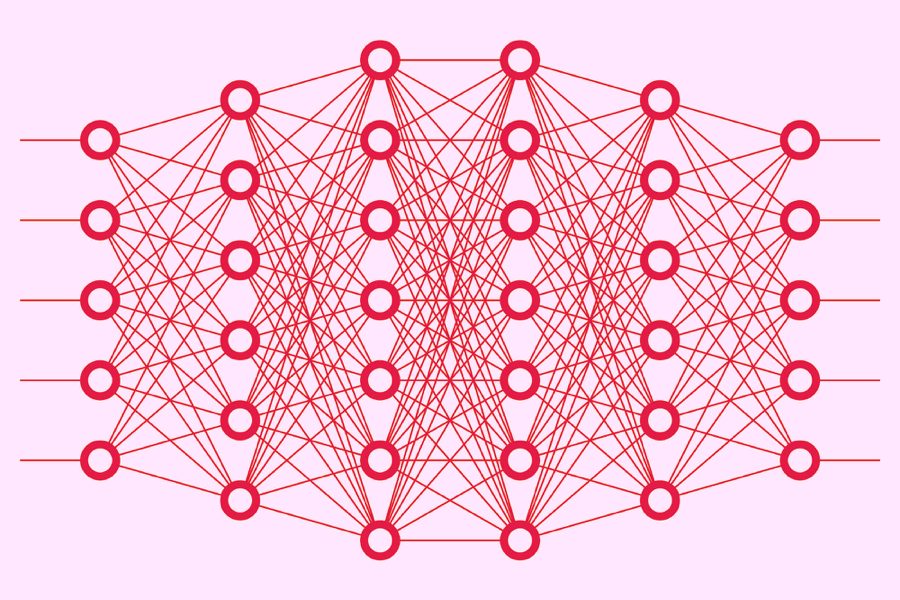

Le deep learning est un sous-ensemble des techniques de machine learning à base de réseaux de neurones artificiels. Les réseaux de neurones artificiels sont composés de neurones formels. Par analogie avec les neurones biologiques, les neurones formels possèdent des pendants mathématiques et informatiques de dendrites, d’axones et de synapses. Dans le cas du deep leaning, l’architecture du réseau permet de décomposer de manière hiérarchique le contenu d’une donnée complexe, telle qu’une voix ou une image de visage pour ensuite la catégoriser.

Les applications du deep learning sont au cœur de la montée en puissance du thème de l’intelligence artificielle depuis une quinzaine d’années. Elles consistent fondamentalement à opérer des tris et permettent d’automatiser des tâches allant de la reconnaissance faciale à l’analyse d’images médicales, en passant par le tri robotisé de fruits.

L’avantage de la machine n’est pas seulement une question d’automatisation et de rapidité. Le deep learning peut aussi permettre des tris là où la perception humaine n’est pas à son avantage, par exemple pour reconnaître des visages dans l’obscurité par détection des ondes infrarouges.

2. Le défi de l’explicabilité

Le deep learning a pour caractéristique essentielle de ne pas s’appuyer sur des règles fixées en amont de l’apprentissage. Le deep learning est une boîte noire qui ne donne pas accès aux règles ou aux facteurs de catégorisation, et les règles implicites qui résultent de l’apprentissage sont par conséquent difficiles à expliciter. Ce point limite la fiabilité du deep learning.

Le défi de l’explicabilité indique la prochaine étape dans le développement de l’intelligence artificielle. Le but visé est la capacité à fonctionner de manière robuste dans un univers incertain, caractérisé par des informations lacunaires, en exploitant une multitude de dimensions pour s’adapter à des contextes imprévisibles.

3. Briques technologiques

Sur le plan théorique, les techniques statistiques du deep learning n’ont rien de fondamentalement neuf. C’est l’augmentation du rapport performance/coût des ordinateurs qui a changé la donne et remis ces techniques statistiques à l’ordre du jour. Le rapport performance / coût profite également de l’émergence de solutions hardware spécialisées, conçues par des fournisseurs de cartes graphiques.

4. Acteurs

L’expression « deep learning » date de la seconde moitié des années 1980 et a été relancée notamment par Yann le Cun, actuel directeur du laboratoire d’IA de Facebook en France. Tous les géants de l’Internet utilisent le deep learning.

La dimension géopolitique des applications du deep learning s’affirme par ailleurs de façon nette à travers l’actuel regain de l’innovation de défense parmi les grandes puissances (1, 2, 3). La DARPA a notamment proposé différents défis technologiques liés au deep learning, tels ceux des véhicules autonomes entre 2005 et 2007 et puis, plus récemment, autour de l’IA explicable. Les appels à projet actuels touchent aussi bien les questions d’explicabilité que les aspects énergétiques ou de sécurité.

Laurence Devillers est l’une des spécialistes de la question de l’explicabilité.

5. Conséquences éthiques

Les systèmes de surveillance et de reconnaissance faciale dans les espaces publics en Chine s’appuient sur le deep learning.

En Occident, l’une des discussions majeures porte sur les biais contenus dans les données, qui conduisent à des applications de deep learning qui reproduisent des discriminations sociales jugées indésirables. Mais la crainte existe aussi d’aboutir à des intelligences artificielles, par exemple militaires, qui ne tiendraient pas compte de certaines distinctions éthiques.

La possibilité effrayante d’utiliser le deep learning pour créer des « deep fakes » est un autre sujet incontournable. Les deep fakes, ce sont des animations vidéo dont le caractère synthétique est difficile à détecter. Les techniques permettant de réaliser ce type de vidéos sont accessibles en open source. Face au deep learning, nous devons donc réapprendre les vertus du scepticisme.